الذكاء الاصطناعي والعقل البشري في حلبة المواجهة فمن سيثبت جدارته..؟

كنا وما زلنا منذ عقود نحاول تطوير الذكاء الاصطناعي لجعله أقرب للعقل البشري، وقمنا بصنع العديد من الأجهزة تارة كانت تؤدي إنجاز عظيم وتمنحنا نتائج مبهرة وتارة أخرى ترتكب أخطاء وخيمة تقذف بنا إلى الهاوية. وإلى الآن و بعد ستة عقود من الزمن بقيت محاولاتنا لجعل الآلات تحاكي أهدافنا وتطلعاتنا وقيمنا موضوعاً معقداَ. فكلما قام فريق مختص في مجال معين في الذكاء الاصطناعي بحل جزء من مشكلة محاكاة الذكاء الإنساني خلّف فجوات معقدة أكثر في مجالات أخرى بالغة الأهمية.

وسنسلط الضوء على كتاب مشاكل المحاكاة الذي يكشف الصعوبة التي يواجها الذكاء الاصطناعي في محاكاة القيم البشرية.

يناقش برايان كريستيان آلا وهو مبرمج وباحث، في كتابه الأخير مشاكل المحاكاة: تعلم الآلات والقيم البشرية التحديات التي تواجهنا في جعل نماذج الذكاء الاصطناعي تطبق عاداتنا وقيمنا وتفهم ما نعنيه أو نقصده، والأهم من ذلك أن تفعل ما نريده.

يصف برايان الوضع قائلاً: “كلما تطورت أنظمة تعلُم الآلات بالانتشار والقوة بآن واحد، سنجد أنفسنا بموقع الساحر المدرب حيث نستحضر قوة مطاوعة، ونعطيها تعليماتٍ معينة ثم نهرع لإيقافها حالما نجد أن تعليماتنا كانت ناقصة أو غير دقيقة، خشية أن تقوم الآلة بما طلبناه منها بطريقة حقاً ذكية ولكن رهيبة. وركز كريستيان في كتابه أيضاً على الواقع الحالي للذكاء الاصطناعي وكيف وصلنا إلى هذه النقطة، و ناقش فكرة ما العناصر المفقودة في المناهج المختلفة في مجال إنتاج الذكاء الاصطناعي.

التعلم الآلي: ربط المدخلات مع المخرجات

حققت الأنظمة الرمزية (symbolic systems ) في العقود السابقة لأبحاث الذكاء الاصطناعي تقدماَ ملحوظاً في حل المشاكل المعقدة التي تتطلب تفكيراَ منطقياَ. ولكنها في ذات الوقت كانت سيئة في أداء مهمات بسيطة يتعلمها الانسان منذ الصغر مثل الكشف عن الأشياء والناس والأصوات. علاوة عن ذلك فإنها تتطلب الكثير من الجهد اليدوي لتصنع القواعد والمعرفة التي تحدد سلوكهم.

في الآونة الأخيرة ساعد الاهتمام المتزايد في التعلم الآلي والتعلم الآلي الذاتي تطوير الرؤية الحاسوبية والتعرف على الكلام ومعالجة اللغات الطبيعية وهذا ما كان صعباً على أنظمة الذكاء الاصطناعي الرمزية تحقيقه.

ولكن خوارزميات التعلم الآلي هي بالأصل وظائف رياضية معقدة تربط الملاحظات الفكريّة بالنتائج الفعلية بالرغم من إنجازاتها المذهلة. وتبعاَ لذلك فإنها جيدة بقدر ما تكون بياناتها جيدة فإذا ما صادفها شيء مخالف لما رأته خلال التدريبات تبدأ بالتعطل. ويتناول كريستيان في كتابه العديد من الأمثلة التي تُظهر كيف سببت خوارزميات التعلم الآلي العديد من الإخفاقات المحرجة والمدمرة. فعلى سبيل المثال خوارزمية تصنيف الصور الخاصة بشركة Googleالتي ربطت الناس ذوي البشرة السمراء مع الغوريلا. إن المشكلة هنا ليست بخوارزمية الذكاء الاصطناعي بل ببيانات التدريب ، فلو أن فريق شركة Google قام بتدريب النموذج على أمثلة أكثر عن ناس ذوي بشرة سمراء لتمكنت من تفادي مثل هذه الكارثة. وعند هذه النقطة كتب كريستيان أن مثل هذا النظام الذي يتعلم أي شيء من الأمثلة سيبقى تحت رحمة هذه الأمثلة.

والأسوأ من ذلك هو عدم قدرة التعلم الآلي على التمييز بين الصواب والخطأ أو أخذ قرارات أخلاقية. بمعنى آخر أي ثغرة في بيانات تدريب النموذج ستنعكس في أدائه و غالبا بشكل مشين وغير لائق. ففي مثال آخر في عام 2018 أغلقت Amazon أداة تعلم آلي تُستخدم في صنع قرارات التوظيف لأن قراراتها كانت منحازة ضد النساء. لم يرد أحد من فريق الشركة أن يقوم النموذج باختيار المرشحين بناء على جنسهم وهذا ما عكسته بيانات تاريخ التوظيف في شركة Amazon نفسها. وهذه هي واحدة من الحالات التي تظهر التحيزات العنصرية الموجودة في بيانات تدريب نموذج معين ومما يجعلها أيضاً غير موثوقة.

صياغة نماذج عن العالم كما هو يعد تغييراَ له بطريقة ما أو بأخرى فكما يقول كريستيان أن التوظيف الغير دقيق لهذه النماذج قد ينتج دائرة تقييم لا يمكننا النجاة منها وقد يتطلب تدخلات كثيرة.

على الذكاء البشري أن يبذل الكثير من الجهد في تجميع البيانات وإيجاد الأنماط ومن ثم تحويلها لأفعال. ولكننا بينما نقوم بتبسيط صنع القرارات الذكي لمجموعة مدخلات ومخرجات فإن تحديات التعلم الآلي تُظهر أن فرضياتنا عن البيانات والتعلم الآلي خاطئة.

كما يحذر كريستيان بأنه علينا أن نأخذ بعين الاعتبار من أين نحصل على بيانات تدريبنا ومن أين نحصل على التصنيفات التي ستعمل في نظامنا كأساس لتحديد الحقائق.

التعليم المعزز: مضاعفة المكافآت

لقي التعليم المعزز رواجاً في العقد المنصرم وهو فرع من الذكاء الاصطناعي. وهو عبارة عن مجموعة جزئية من التعلم الآلي والذي يُعطى به مجموعة من القواعد لمجال مشكلة ما ودالة مكافأة ومن ثم يتم إفساح المجال للنموذج لاكتشاف المحيط بنفسه وإيجاد طرق لزيادة جوائزه. ساعد التعليم المعزز الباحثين في صنع ذكاء اصطناعي حقق نجاحات بارزة مثل تحقيق البطولات في ألعاب الفيديو.

يقول برايان كريستيان “يقدم التعليم المعزز تعريفاً قوياً بل حتى عالمياً عما يعنيه الذكاء”.

يُعد التعليم المعزز السبب الكامن خلف إنجازات علمية عظيمة مثل أنظمة الذكاء الاصطناعي التي احترفت ألعاب Atari و StarCraft 2و DOTA 2 واستخدمت في العديد من الآليات. ولكن كل من هذه الإنجازات أثبتت أيضاُ أن طريقة عمل الذكاء هي ليست تحديداُ السعي وراء المكافئات الخارجية.

ولكن هناك شيئاً واحد ألا وهو أن نماذج التعليم المُعزز تتطلب كميات هائلة من حلقات التدريب لاكتساب نتائج بسيطة. ولهذا فإن البحث في هذا المجال مقتصر على عدد قليل من المختبرات الممولة من قبل شركات غنية.

أنظمة التعليم المعزز صارمة جداً، فعلى سبيل المثال نموذج تعليم معزز مصمم للعب لعبة StarCraft 2 بمستوى البطولة لن يكون قادراً على لعب لعبة أخرى. يميل أيضاً عملاء التعليم المعزز للعجز عن متابعة حلقات فارغة حيث تتضخم مكافأة بسيطة على حساب أهداف طويلة المدى. فمثلاً، تمكّن زورق السباق الذي يتمتع بذكاء اصطناعي من اختراق بيئته بتجميع عناصر المكافئات بشكل مستمر بدون التفكير بالهدف الأسمى بربح السباق.

يقترح كريستيان أن التعليم المعزز يبدأ بمكافآت وينتهي بسلوك يزيد هذه المكافآت ولكن العكس يبدو مثيراً للاهتمام أكثر، إذ يقول: “أداء السلوك الذي نريده من آلاتنا يطرح سؤالاً عن كيفية تأسيس بيئة المكافآت للحصول على ذلك السلوك. كيف سنحصل على ما نريده عندما نكون نحن الجالسون خلف الجمهور أو كرسي الناقد فنحن من يدير حبيبات الطعام أو مقابلها الرقميّ؟

هل على الذكاء الاصطناعي محاكاة البشر؟

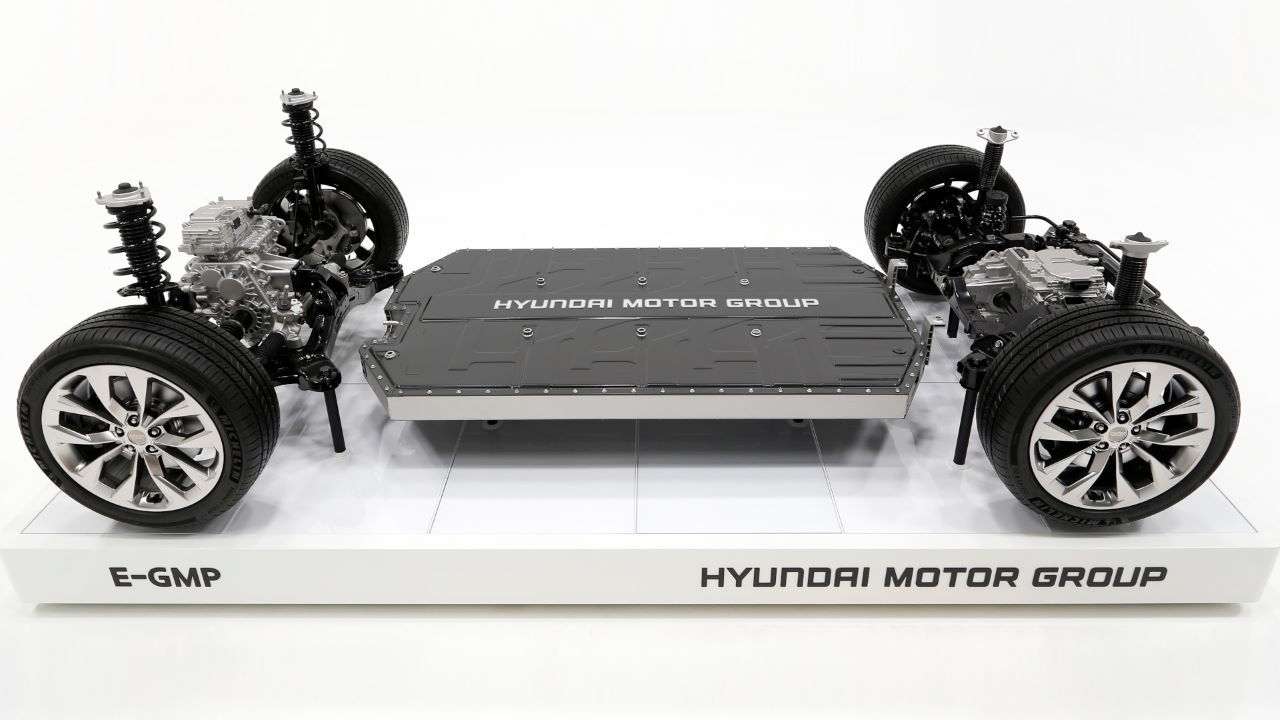

يناقش كريستيان في كتابه مشكلة المحاكاة تداعيات تطوير عملاء الذكاء الاصطناعي التي تتعلم من خلال محاكاة بحتة للتصرفات البشرية. على سبيل المثال السيارات ذاتية القيادة التي تتعلم من خلال مراقبة البشر كيف يمارسون القيادة.

يمكن للمحاكاة أن تفعل العجائب خصوصاً في التسبب بالمشاكل حيث تكون القواعد والتصنيفات ليست واضحة. إذ أن المحاكاة ترسم صورة غير مكتملة عن أحجية الذكاء. نحن نتعلم الكثير من خلال المحاكاة والتعلم عن ظهر قلب خصوصاً في سنٍ صغير بالرغم من كونها واحدة من السبل التي نطوّر بها سلوكنا العقليّ. فمن خلال مراقبتنا للآخرين يمارسون سلوكاً معيناً، نحن نكوّن هذا السلوك ولكن حسب حدودنا وأهدافنا وتطلعاتنا وحاجاتنا وقيمنا. إذ كتب كريستيان: ” لن تنجح محاولتك لتقليد شخص بالأصل أسرع منك أو أقوى منك أو حتى حجمه مختلف عن حجمك أو سريع التفكير.” فبالتأكيد ستكون محاولة مأساوية. ستفعل ما تريد فعله لو كنت هو ولكنك لست هو! وما تقوم به ليس ما قد يقوم به هو لو كان أنت.”

في حالات أخرى، تُحاول أنظمة الذكاء الاصطناعي استخدام المحاكاة لملاحظة وتوقّع سلوكنا ومن ثم محاولة مساعدتنا. ولكن هذا أيضاً يمثل تحدياً لأن هذه الأنظمة ليست مقيدة بنفس ضوابطنا وحدودنا مثلما نحن بالعكس وغالباً ما نسيء فهم ما نريده وما الجيد لنا. بدلاً من حمايتنا من عاداتنا السيئة، تقوم بتضخيمها ودفعنا لاكتساب عادات الآخرين السيئة. فيصبح دورهم متغلغلاً في كل جانب من حيواتنا.

كتب كريستيان أن المساعدين الرقميين الذين نستخدمهم يلاحظون حياتنا الخاصة والعامة وذواتنا السيئة والخيرة ولكنهم غير قادرين على التفريق بينهم، فهم لديهم القدرة على استنباط أمثلة معقدة عن رغباتنا من خلال سلوكنا، وهم يفكرون ملياً بماذا نريد أن نفعل لاحقاً وبماذا قد نأمرهم، ولكن لا يبدو أنهم يفهمون ماذا نريد أو ماذا على الأقل نأمل أن نصبح.

ما الذي سيحدث لاحقاً وما الذي تخبئه الأيام على هذا الصعيد؟

تُظهر التطورات في التعلم الآلي مقدار التقدم الذي أحرزناه إثر صنع آلات مُفكّرة. ولكن التحديات الخاصة بالتعلم الآلي ومشكلة المحاكاة تُذكرنا أيضاً كم علينا أن نتعلم قبل صنع ذكاء ذو مستوى بشريّ. يستكشف علماء وباحثو الذكاء الاصطناعي العديد من الطرق التي تستطيع أن تنفع البشرية بدون التسبب بالأذى. حتى ذلك الحين علينا أن نكون حذرين عندما نعطي صلاحيات لأنظمة تُحاكي الذكاء البشريّ من الخارج. يحذر كريستيان أن “أحد أخطر الأشياء التي يستطيع الإنسان فعلها في التعلم الآلي هي إيجاد نموذج، جيد إلى حدٍ ما يُعلن النصر، بحيث نصبح غير قادرين على إيقافه أو التحكم به”

ليبقى السؤال الذي يطرح نفسه هل محاولة الإنسان لتطوير الذكاء الاصطناعي، ستسمو به نحو مستقبل أكثر رفاهية وأكثر أمانا أم أنه سينقلب السحر على الساحر..؟!